القانون الأوروبي لـ «الذكاء الاصطناعي».. «خوارزميات» الدمار

يتحرك الاتحاد الأوروبي بقوة، لمواجهة العواقب الوخيمة لتقنيات الذكاء الاصطناعي، والتي وصفها الاتحاد أنها باتت قريبة من أن تخرج عن الحدود والسيطرة، لتدمير أحلام وأمال البشر.

وبحسب ما نقلت صحيفة «الجارديان» البريطانية، فقال كاليينا ماكورتوف مراسل الشؤون المصرفية، أن الأمر بدأ بتغريدة واحدة في نوفمبر 2019، حين هاجم ديفيد هاينماير هانسون، رائد الأعمال التكنولوجي البارز، بطاقة الائتمان التي أطلقتها شركة آبل حديثًا، واصفا إياها بأنها "متحيزة ضد المرأة"، لأنها قدمت لزوجته حد ائتمانيًا أقل بـ 20 مرة من حده الائتماني.

انتشرت بعد ذلك المزاعم كالنار في الهشيم، حيث شدد هانسون على أن الذكاء الاصطناعي - الذي يستخدم الآن على نطاق واسع في اتخاذ قرارات الإقراض - هو السبب في ذلك التمييز، وقال :"لا يهم ما هي نية مندوبي آبل Apple الفرديين، من المهم ما تفعله الخوارزمية التي وضعوا إيمانهم الكامل بها".

وفي حين تم تبرئة شركة آبل Apple وشركات التأمين التابعة لها Goldman Sachs في نهاية المطاف من قبل المنظمين الأمريكيين من انتهاك قواعد الإقراض العادل العام الماضي، فقد أعادت إشعال نقاش أوسع حول استخدام الذكاء الاصطناعي في الصناعات العامة والخاصة.

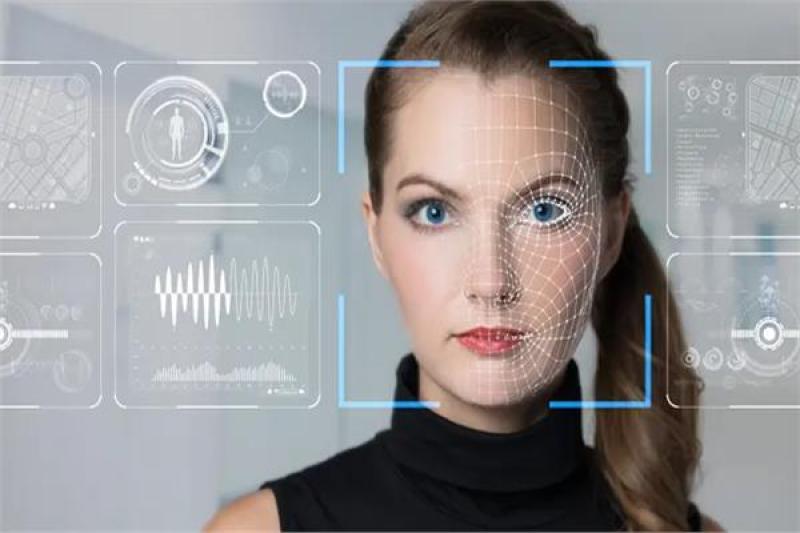

ويخطط السياسيون في الاتحاد الأوروبي الآن، لتقديم أول نموذج عالمي شامل لتنظيم الذكاء الاصطناعي، حيث تقوم المؤسسات بشكل متزايد بأتمتة المهام الروتينية في محاولة لتعزيز الكفاءة وخفض التكاليف في نهاية المطاف.

وسيكون لهذا التشريع، المعروف باسم قانون الذكاء الاصطناعي، عواقب خارج حدود الاتحاد الأوروبي، وسينطبق مثل اللائحة العامة لحماية البيانات في الاتحاد الأوروبي على أي مؤسسة، بما في ذلك بنوك المملكة المتحدة، تخدم عملاء الاتحاد الأوروبي.

وقال ألكسندرو سيرسيومارو، رئيس السياسة العامة الأوروبية في معهد أدا لوفليس: "تأثير القانون، بمجرد اعتماده، لا يمكن المبالغة فيه".

واعتمادًا على القائمة النهائية للاتحاد الأوروبي للاستخدامات "عالية المخاطر"، هناك دافع لإدخال قواعد صارمة حول كيفية استخدام الذكاء الاصطناعي لتصفية الوظائف، أو الجامعات، أو طلبات الرعاية ، أو - في حالة المقرضين - تقييم الجدارة الائتمانية للمقترضين المحتملين.

ويأمل مسؤولو الاتحاد الأوروبي، أنه مع مزيد من الإشراف والقيود على نوع نماذج الذكاء الاصطناعي التي يمكن استخدامها، فإن القواعد ستحد من نوع التمييز القائم على الآلة الذي يمكن أن يؤثر على القرارات التي تغير الحياة مثل ما إذا كان بإمكانك تحمل تكاليف منزل أو قرض طالب .

وقالت سارة كوتشيانسكي، مستشارة تكنولوجيا مالية مستقلة: "يمكن استخدام الذكاء الاصطناعي لتحليل صحتك المالية بالكامل، بما في ذلك الإنفاق، والادخار والديون الأخرى، للوصول إلى صورة أكثر شمولية"، وأضاف: "إذا تم تصميم هذه الأنظمة بشكل صحيح، يمكن أن توفر وصولاً أوسع إلى ائتمان ميسور التكلفة."

لكن أحد أكبر المخاطر هو التحيز غير المقصود، حيث تنتهي الخوارزميات برفض القروض، أو الحسابات لمجموعات معينة بما في ذلك النساء، أو المهاجرين، أو الأشخاص الملونين.

الإعلانات

وجزء من المشكلة، فأن معظم نماذج الذكاء الاصطناعي، لا يمكنها التعلم إلا من البيانات التاريخية التي تم تغذيتها بها، مما يعني أنها ستتعلم أي نوع من العملاء تم إقراضهم في السابق وأي العملاء تم تصنيفهم على أنهم غير موثوق بهم.

وقال كوتشيانسكي: "هناك خطر من أن يكونوا منحازين فيما يتعلق بالشكل الذي يبدو عليه المقترض" الجيد "، وأضاف: "تجدر الإشارة إلى أن الجنس والعرق غالبًا ما يلعبان دورًا في عمليات صنع القرار في الذكاء الاصطناعي، استنادًا إلى البيانات التي تم تدريسها عليها العوامل التي لا صلة لها بأي حال من الأحوال بقدرة الشخص على سداد القرض."

وعلاوة على ذلك، تم تصميم بعض النماذج بحيث تتجاهل ما يسمى بالخصائص المحمية، مما يعني أنه لا يُقصد منها مراعاة تأثير الجنس أو العرق أو العرق أو الإعاقة، لكن نماذج الذكاء الاصطناعي هذه لا تزال قادرة على التمييز نتيجة لتحليل نقاط البيانات الأخرى مثل الرموز البريدية، والتي قد ترتبط بالفئات المحرومة تاريخياً التي لم تتقدم من قبل بطلب للحصول على قروض، أو رهون عقارية، أو مضمونة، أو مسددة من قبل.

وفي حين أن القواعد الجديدة للاتحاد الأوروبي، من المرجح أن تكون خطوة كبيرة في الحد من التحيز القائم على الآلة، فإن بعض الخبراء، بمن فيهم أولئك في معهد Ada Lovelace، يضغطون من أجل أن يكون للمستهلكين الحق في تقديم شكوى والتماس الإنصاف إذا اعتقدوا أنه تم تقديمهم، على نحو سيء.

وقال سيرسيومارو: "إن المخاطر التي يشكلها الذكاء الاصطناعي، خاصة عند تطبيقها في ظروف معينة حقيقية، وهامة وموجودة بالفعل".

وأضاف: "يجب أن يضمن تنظيم الذكاء الاصطناعي حماية الأفراد بشكل مناسب من الأذى من خلال الموافقة على استخدامات الذكاء الاصطناعي أو عدم الموافقة عليها، وإتاحة الحلول في حالة تعطل أنظمة الذكاء الاصطناعي المعتمدة أو حدوث أضرار."

وتابع: "لا يمكننا التظاهر بأن أنظمة الذكاء الاصطناعي المعتمدة ستعمل دائمًا بشكل مثالي وتفشل في الاستعداد للحالات التي لا تفعل فيها ذلك ".